Silent Breach ✴️ Eine Abrechnung mit dem IT-Standard im Mittelstand

- Marc Borgers

- 20. Dez.

- 16 Min. Lesezeit

Ein weit verbreiteter Irrtum im Management kleiner und mittelständischer Unternehmen ist die Annahme, die eigene Organisation sei für professionelle Cyberkriminelle zu unbedeutend. Dieses „Security by Obscurity“-Denken und die Hoffnung, in der Masse unterzugehen, stellt heute eines der größten operativen Risiken dar. Die Bedrohungslage hat sich fundamental gewandelt. Sie bewegt sich weg von der breiten Streuung und hin zur präzisen Kompromittierung ausgewählter Ziele.

Der Paradigmenwechsel: Von der Gießkanne zum Scharfschützen

Historisch betrachtet basierte Cyberkriminalität oft auf dem Prinzip der großen Zahl. SPAM-Kampagnen und generische Ransomware wurden millionenfach versendet. Die Täter agierten in der Erwartung, dass ein geringer Prozentsatz der Empfänger unvorsichtig agiert. Gegen diese statischen Bedrohungen bieten herkömmliche Signatur-Scanner einen soliden Grundschutz.

Die heutige Realität in der IT-Forensik zeigt jedoch eine Zunahme sogenannter Targeted Attacks. Hierbei setzen Angreifer auf polymorphe Malware. Dabei wird der Schadcode für jedes Opfer oder jede kleine Opfergruppe neu kompiliert oder gepackt. Der funktionale Kern der Software bleibt identisch, doch der digitale Fingerabdruck ändert sich vollständig. Für klassische und signaturbasierte Abwehrmechanismen ist jede dieser Dateien ein Unikat und somit zunächst unbekannt sowie unverdächtig. Der Angreifer agiert nicht mehr wie ein Artillerie-Sperrfeuer, sondern wie ein Scharfschütze.

Der Trugschluss der Irrelevanz: Das Konzept der „Soft Targets“

Warum sollten Kriminelle diesen Aufwand für eine Kanzlei, ein Ingenieurbüro oder ein Family Office betreiben? Die Antwort liegt in der Wertdichte der Daten im Verhältnis zum Aufwand des Eindringens.

Großkonzerne verfügen über Security Operations Center und massive Abwehrbudgets. KMUs hingegen verwalten oft Daten von identischer Sensibilität. Dazu zählen Fusionspläne, Patentzeichnungen, strafrechtliche Ermittlungsakten oder Vermögensdaten. Sie schützen diese jedoch häufig mit Consumer-Hardware und Standard-Softwarekonfigurationen. Sie gelten in der Angreifer-Terminologie als „Soft Targets“. Eine Kompromittierung dient hierbei oft zwei Zielen. Zum einen der direkten Verwertung durch Erpressung bei Androhung einer Veröffentlichung sensibler Daten. Zum anderen dienen sie als Sprungbrett für Supply Chain Attacks. Hierbei wird die vertrauenswürdige Infrastruktur des KMU genutzt, um größere Partner oder Mandanten anzugreifen.

Die Metrik des Schreckens: Wenn Telemetrie schweigt

Ein entscheidender Indikator für die Schwere eines Vorfalls ist die globale Verbreitung einer Schadsoftware. Sicherheitsverantwortliche und IT-Dienstleister müssen lernen Telemetrie-Daten korrekt zu interpretieren.

Meldet eine Sicherheitsplattform oder ein Cloud-gestützter Virenscanner, dass eine identifizierte Schadsoftware weltweit millionenfach gesehen wurde, handelt es sich meist um Massenware. Meldet die Telemetrie jedoch, dass eine Datei weltweit über Monate nur auf einer zweistelligen Anzahl von Geräten existiert, muss dies die höchste Alarmstufe auslösen. Eine solch geringe Verbreitung ist statistisch bei legitimer Standardsoftware kaum zu erwarten. Im Kontext von Malware ist diese Zahl ein starkes Indiz dafür, dass die Datei exklusiv für einen winzigen Kreis von Zielen erstellt wurde. Es spricht mit hoher Wahrscheinlichkeit für Industriespionage oder eine gezielte APT-Kampagne. In diesem Szenario ist das betroffene Unternehmen vermutlich kein zufälliges Opfer und es ist das definierte Ziel einer Operation.

Technologie-Paradigma: Die Grenzen von Signaturen und Machine Learning

Die rasante Evolution der Offensivtechnologien hat die traditionellen Abwehrmechanismen vieler Unternehmen faktisch obsolet gemacht. Sicherheitsverantwortliche müssen akzeptieren, dass der klassische Virenscanner als alleinige Verteidigungslinie versagt. Dies liegt nicht an mangelnder Qualität der Produkte und es liegt auch nicht an Fehlkonfigurationen. Die Ursache ist ein fundamentaler Wandel in der Architektur sowie der Verteilung moderner Schadsoftware.

Das Versagen des Vertrauensmodells: Die Zertifikats-Lücke

Ein zentrales Einfallstor für hochkomplexe Angriffe ist das Vertrauen von Betriebssystemen in digitale Signaturen. Extended Validation Zertifikate gelten als Goldstandard für Identität im Softwareumfeld. Kriminelle Akteure nutzen dies aus und erwerben diese Zertifikate über Briefkastenfirmen oder durch Diebstahl regulär. Eine mit einem solchen Zertifikat signierte Malware wird von Schutzmechanismen wie dem Microsoft SmartScreen Filter oft anders bewertet als unsignierter Code. Der Angreifer nutzt dies gezielt aus um Warnmeldungen zu unterdrücken oder Vertrauen zu simulieren. Er erkauft sich somit eine Tarnkappe und senkt die Hürde für die erste Verteidigungslinie noch bevor die erste Zeile Schadcode ausgeführt wird.

KI-gestützte Polymorphie: Malware schreibt sich selbst neu

Die größte Bedrohung geht heute von der Integration künstlicher Intelligenz in die Entwicklung von Schadsoftware aus. Klassische polymorphe Viren nutzten Packer oder Verschlüsselung zur Verschleierung. Generative KI und Large Language Models heben dieses Prinzip auf eine neue Stufe. Moderne Malware ist in der Lage ihren Quellcode vor jedem Angriff oder sogar während der Laufzeit aktiv umzuschreiben.

Angreifer nutzen KI-Modelle zur Obfuskation. Sie behalten die Programmlogik semantisch gleich und verändern die Syntax vollständig. Variablennamen werden ausgetauscht und Kontrollflussstrukturen werden modifiziert sowie unnützer Code wird eingefügt. Dies führt dazu, dass jeder erzeugte Schädling ein Unikat ist und keine statische Signatur greifen kann. Die Malware erfindet sich für jedes Ziel neu und individualisiert sich automatisch anhand der vorgefundenen Umgebung.

Autonome Reaktion und Evasion

Die neue Generation von Malware agiert nicht mehr als starres Skript. Sie arbeitet als autonomer Agent. Durch integrierte KI-Komponenten ist die Schadsoftware fähig ihre Umgebung in Echtzeit zu analysieren und auf Bedrohungen zu reagieren. Erkennt der Agent eine Sandbox oder Analyseumgebung eines Virenscanners, stellt er seine schädlichen Aktivitäten ein oder ändert sein Verhalten. Diese Evasion Techniken sind dynamisch und lernen aus fehlgeschlagenen Versuchen. Die Malware wartet geduldig und prüft Benutzeraktivitäten wie Mausbewegungen und schlägt erst zu, wenn sie sich sicher in einem produktiven System wähnt.

Die Analyse moderner Angriffs-Tools zeigt eine beunruhigende Integrität von Abwehrmechanismen direkt im Schadcode. Die Software verhält sich nicht deterministisch und sie passt sich dynamisch an. Reale Analysen belegen den Einsatz spezifischer API-Aufrufe zur Erkennung von Laborumgebungen.

Zeit-Manipulation: Der Code nutzt Befehle wie Sleep oder GetTickCount und vergleicht Systemzeiten. Damit wird geprüft, ob die Zeit schneller vergeht als in der Realität üblich oder ob ein Debugger den Ablauf verzögert. Sandboxes beschleunigen oft die Zeit, um Wartephasen zu überspringen. Die Malware erkennt dies und bleibt inaktiv.

Hardware-Fingerprinting: Über WMI-Abfragen wie Win32_BIOS oder Win32_BaseBoard scannt der Agent die Hardware-ID. Er sucht gezielt nach Artefakten gängiger Virtualisierungslösungen oder forensischer Tools. Findet er Hinweise auf eine virtuelle Maschine statt echter Hardware, bricht die Infektionskette ab.

Debugger-Detektion: Routinen wie IsDebuggerPresent prüfen aktiv, ob der Prozess durch einen Analysten überwacht wird.

Das Resultat ist eine „Schrödingers Malware“. Sie ist in der Analyseumgebung harmlos und in der Produktionsumgebung tödlich. Dies führt zu fatalen Fehleinschätzungen bei automatisierten Scans („Clean“), während das System im Hintergrund kompromittiert wird.

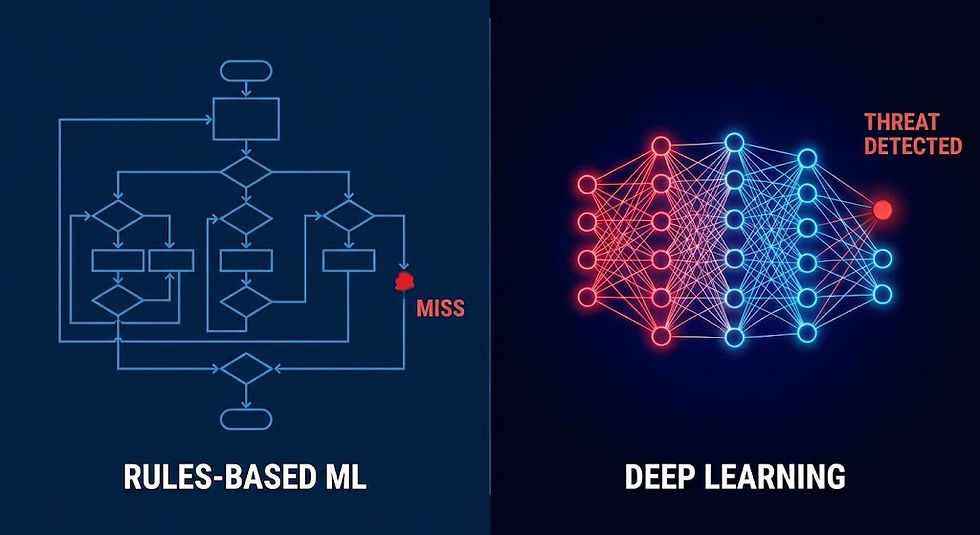

Deep Learning vs. Machine Learning: Der notwendige Technologiesprung

In der Defensive reicht herkömmliches Machine Learning gegen diese Bedrohungen oft nicht mehr aus. Traditionelles ML basiert meist auf manuell definierten Merkmalen und benötigt eine gewisse Zeit für das Erlernen neuer Angriffsmuster. Bei KI-generierten Angriffen ist diese Latenz zu hoch.

Die Antwort auf KI-gestützte Angriffe liegt zunehmend im Einsatz von Deep Learning. Lösungen wie die 🔗 in dem Artikel "Schutz vor Malware: Stand der Technik" beschriebenen oder ähnliche fortschrittliche Plattformen nutzen neuronale Netze. Diese werden auf Rohdaten trainiert und sind nicht auf menschliche Vorselektion von Merkmalen angewiesen. Sie sind in der Lage bösartige Muster in Dateien präventiv zu erkennen und diese zu stoppen. Dies gilt selbst dann wenn diese noch nie zuvor gesehen wurden und massiv obfuskiert sind. Während ML-Lösungen oft reaktiv klassifizieren, ermöglicht DL eine prädiktive Bewertung. Der Einsatz einer solchen Second Opinion Lösung ist heute kein Luxus mehr sowie eine operative Notwendigkeit. Nur so lassen sich die blinden Flecken der Standardlösungen ausleuchten und die technologische Asymmetrie zwischen Angreifer und Verteidiger ausgleichen.

Der blinde Fleck der Infrastruktur: Consumer-Hardware im Unternehmenskontext

Eine robuste IT-Sicherheitsstrategie basiert auf dem Prinzip der Tiefenverteidigung oder „Defense in Depth“. Wenn der Endpunkt-Schutz versagt und die Malware auf dem Rechner aktiv ist, muss die Netzwerk-Infrastruktur als zweite Verteidigungslinie greifen. In vielen kleinen und mittelständischen Unternehmen existiert diese Linie faktisch nicht. Der Einsatz von Consumer-Hardware im geschäftlichen Umfeld schafft einen blinden Fleck von kritischer Dimension.

Die SOHO-Falle: Konnektivität vor Sicherheit

Geräte aus dem Consumer-Bereich sind auf Benutzerfreundlichkeit und maximale Konnektivität ausgelegt. Sie sollen Internetzugang gewähren und Streaming-Dienste priorisieren sowie WLAN-Abdeckung sicherstellen. Sie sind jedoch nicht darauf ausgelegt detaillierte Sicherheitsanalysen durchzuführen oder Traffic-Ströme granular zu protokollieren.

Ein professioneller Angreifer nutzt diesen Umstand aus. Wenn eine polymorphe Malware den Virenscanner auf dem Client umgeht, ist das Gateway die einzige verbleibende Instanz für die Detektion. Ein Consumer-Router leitet den verschlüsselten Datenverkehr der Malware oft über Port 443 an den Command & Control Server der Angreifer weiter. Für das Gerät unterscheidet sich der Diebstahl von Gigabyte an Mandantendaten technisch nicht vom Upload eines Urlaubsvideos in die Cloud.

Fehlende Beweislast: Das forensische schwarze Loch

Das größte Risiko beim Einsatz von Consumer-Hardware offenbart sich erst im Schadensfall. Sofern personenbezogene Daten betroffen sein können, greifen Melde- und Benachrichtigungspflichten nach Art. 33/34 DSGVO. Die Einstufung hängt von der konkreten Risikobewertung ab.

Hier wird die technische Limitierung zur juristischen Haftungsfalle. Consumer-Router speichern in der Regel keine historischen Verbindungsdaten oder NetFlow-Protokolle über einen längeren Zeitraum. Wenn eine Infektion über Monate unbemerkt blieb, gibt es keine Netzwerk-Logs aus der Vergangenheit. Es lässt sich technisch nicht mehr feststellen, ob an einem Tag im Oktober 5 Kilobyte Textdaten oder 50 Gigabyte Akteninhalte an eine unbekannte IP-Adresse gesendet wurden. Da der Beweis für das Ausbleiben eines Datenabflusses nicht erbracht werden kann, kann dies dazu führen, dass im Rahmen der Risikobewertung von einem ungünstigen Szenario auszugehen ist, wenn ein Abfluss nicht belastbar ausgeschlossen werden kann.

Die Forderung: Egress-Filtering und SSL-Inspektion

Der „Stand der Technik“ für den Schutz vertraulicher Daten entwickelt sich stetig weiter. Je nach Schutzbedarf kann es praktisch erforderlich sein, Enterprise-Funktionen (wie Egress-Kontrollen, zentrale Protokollierung und Policies) einzusetzen. Ob dies über Enterprise-Appliances oder vergleichbare Lösungen realisiert wird, hängt vom Einzelfall ab.

Erstens ermöglicht das sogenannte Egress-Filtering eine Beschränkung des ausgehenden Datenverkehrs. In einem gehärteten Netzwerk darf ein Arbeitsplatzrechner nicht wahllos mit jedem Server im Internet kommunizieren. Er darf nur autorisierte Ziele ansteuern. Der Verbindungsaufbau zu einem unbekannten Server in Übersee würde blockiert und alarmiert werden.

Zweitens ist die Deep Packet Inspection oft notwendig. Da moderne Malware fast ausschließlich verschlüsselte Kanäle nutzt, muss die Firewall in der Lage sein diesen Verkehr mittels TLS-Interception zu inspizieren. Hierbei bricht die Firewall die Verschlüsselung kontrolliert auf und analysiert den Inhalt auf Schadcode oder Datenabfluss sowie verschlüsselt das Paket anschließend neu für den Empfänger. Ohne diese Mechanismen bleibt das Netzwerk für den Sicherheitsverantwortlichen eine Blackbox.

Private Nutzung vs. SSL-Inspektion: Die Diskussion um die Inspektion verschlüsselten Datenverkehrs wird oft von juristischen Bedenken und technischem Halbwissen dominiert. Standards wie der VDA ISA (v6) fordern sogar die automatische Untersuchung der via Gateway unverschlüsselt sowie verschlüsselt übertragenen Daten und dennoch verzichten viele Unternehmen darauf.

Alternativen wie URL-Filter bieten bei gezielten Angriffen oft unzureichenden Schutz. Reputationsdienste arbeiten reaktiv und basieren auf bekannten Schad-Domains. Eine Firewall ohne SSL-Inspektion sieht in diesem Szenario lediglich eine verschlüsselte Verbindung zu einem vertrauenswürdigen Hoster und kann den Abfluss sensibler Daten im Tunnel nicht erkennen.

Ein Sicherheitskonzept ohne Sichtbarkeit im verschlüsselten Datenstrom kann je nach Schutzbedarf und Bedrohungslage zu einer unangemessenen Risikolage führen sowie im Schadensfall als sorgfaltswidrig bewertet werden. Ob der Verzicht auf TLS-Interception vertretbar ist, hängt von einer detaillierten Risikobetrachtung sowie alternativen Kontrollmechanismen ab. Auch die rechtliche Bewertung hat sich gewandelt. Mehrere Aufsichtsbehörden vertreten inzwischen die Auffassung, dass Arbeitgeber bei erlaubter oder geduldeter Privatnutzung regelmäßig nicht mehr als Telekommunikationsanbieter einzuordnen sind. Dies gilt insbesondere seit Inkrafttreten des TTDSG (heute TDDDG). Gleichwohl bleibt die Zulässigkeit von Kontrollen arbeitsrechtlich und datenschutzrechtlich sauber zu regeln. Transparenz gegenüber den Mitarbeitenden und klare Regeln zur Privatnutzung sowie sofern vorhanden die Einbindung der Mitarbeitervertretung und gegebenenfalls die Mitbestimmung nach § 87 Abs. 1 Nr. 6 BetrVG schaffen die nötige Rechtssicherheit.

Die technologische Mittelklasse als Sicherheitsanker

Die Forderung nach professioneller Netzwerksicherheit ist nicht gleichbedeutend mit immensen Hardwarekosten. Der Markt bietet leistungsfähige Lösungen im SOHO-Bereich und Open-Source-Umfeld. Plattformen wie OPNsense und pfSense sowie kommerzielle Einstiegslösungen von Anbietern wie Sophos ermöglichen ein Schutzniveau, das dem von Großunternehmen in nichts nachsteht.

Der entscheidende Faktor ist hierbei die Aktivierung spezifischer Module sowie die Integration von Threat Intelligence. Erweiterungen wie pfBlockerNG oder Zenarmor erlauben Administratoren eine granulare Kontrolle. Anfragen an bekannte Malicious Domains werden bereits auf DNS-Ebene verworfen und Geo-Blocking verhindert den Zugriff auf Länder ohne Geschäftsbeziehungen. Diese Systeme protokollieren nicht nur Metadaten. Sie bieten vollständige Transparenz darüber, welcher Client im Netzwerk welche Applikation nutzt und welches Datenvolumen dabei transferiert wird. Im Falle einer forensischen Analyse liefert ein solches System die Beweise, die eine einfache oft FritzBox schuldig bleibt.

Identität und Cloud: Bequemlichkeit als Risikoverstärker

Der technologische Wandel hin zu Cloud-Diensten hat die Arbeitsweise in Unternehmen flexibilisiert sowie beschleunigt. Diese Dezentralisierung der Datenhaltung schafft jedoch neue Angriffsvektoren. Die klassische Grenze des Firmennetzwerks löst sich auf und die Identität des Benutzers wird zum neuen Perimeter. Eine Kompromittierung des Endgeräts hat in diesem Umfeld weitreichendere Konsequenzen als in isolierten Umgebungen.

Das Synchronisations-Dilemma

Dienste wie Microsoft OneDrive oder SharePoint sowie Google Drive basieren auf einer nahtlosen Synchronisation zwischen lokalem Endgerät und Cloud-Speicher. Diese Funktionalität erhöht die Produktivität und wirkt im Falle einer Infektion als Brandbeschleuniger. Eine auf dem Client aktive Malware erhält durch den laufenden Synchronisations-Client Lese- und Schreibzugriff auf den gesamten Cloud-Datenbestand des Benutzers.

Das Risiko beschränkt sich nicht auf die lokale Verschlüsselung durch Ransomware. Moderne „Stealer“ Malware nutzt die bestehende Authentifizierung des Cloud-Clients für die Exfiltration. Der Angreifer muss keine Firewall-Regeln überwinden und er nutzt den legitimen sowie vertrauenswürdigen Kanal der Cloud-Anwendung für den Abfluss sensibler Daten. Die Cloud wird somit ungewollt zum Komplizen bei der Verbreitung sowie beim Diebstahl von Informationen. Lokale Vorfälle globalisieren sich in Echtzeit.

Session Hijacking: Wenn das Passwort wertlos wird

Sicherheitsverantwortliche predigen seit Jahren die Notwendigkeit komplexer Passwörter. Die Realität moderner Cyberangriffe hat diese Strategie teilweise überholt. Der Fokus der Angreifer hat sich vom Diebstahl der Zugangsdaten hin zum Diebstahl der digitalen Identität verlagert.

Browser und Cloud-Anwendungen nutzen sogenannte Session-Tokens oder Cookies für die Komfortfunktion „Angemeldet bleiben“. Diese kleinen Textdateien fungieren als digitaler Ausweis. Eine Malware auf dem Endgerät extrahiert diese Tokens aus den Datenbanken der Webbrowser. Der Angreifer importiert den gestohlenen Token in seinen eigenen Browser und übernimmt die aktive Sitzung des Opfers. Die Gefahr liegt in der Umgehung von Sicherheitsmechanismen. Da das Token von einer bereits erfolgreich durchgeführten Anmeldung stammt, wird eine aktive Multi-Faktor-Authentifizierung (MFA) ausgehebelt. Der Server vertraut dem Token und fragt keinen zweiten Faktor mehr ab. Der Angreifer hat Vollzugriff auf E-Mails sowie Cloud-Speicher und CRM-Systeme ohne das Passwort jemals gekannt zu haben.

Architekturvergleich: Sicherheitskonzepte im Härtetest

Der Einsatz von Passwort-Managern ist unverzichtbar. Im Szenario einer aktiven Kompromittierung des Endgeräts durch Spyware zeigen sich jedoch signifikante Unterschiede in den Architekturkonzepten gängiger Lösungen.

Cloud Native Ansätze wie sie beispielsweise 1Password verwendet fokussieren sich auf komfortable Synchronisation und Verschlüsselung mittels „Secret Key“. Der Schutzfaktor gegen Exfiltration hängt hier stark von der Härtung des Betriebssystems und der Nutzung von Hardware-Ankern wie TPM ab.

Im Vergleich dazu setzen On-Premise orientierte Ansätze (beispielsweise Password Depot) oder Open Source Lösungen (KeePass) oft auf lokale Härtung. Funktionen wie virtuelle Tastaturen oder „Secure Desktops“ zielen darauf ab das Abgreifen von Eingaben durch Malware zu erschweren. Ein wesentlicher architektonischer Unterschied liegt zudem in der möglichen Nutzung von Schlüsseldateien auf externen Medien. Diese physische Trennung kann im Falle eines reinen Datenabflusses eine zusätzliche Hürde darstellen. Vorausgesetzt sie werden umgesetzt und konsequent genutzt.

Welcher Ansatz der richtige ist, hängt vom individuellen Bedrohungsmodell und der Balance zwischen Komfort sowie Sicherheit ab. Der Stand der Technik verlangt daher eine Entkopplung von Wissen und Besitz. Die Absicherung kritischer Zugänge darf nicht allein auf einem Passwort basieren. Sicherheit entsteht in einer kompromittierten Umgebung nicht durch Geheimhaltung allein und sie entsteht durch die Kombination verschiedener Faktoren, die ein Angreifer aus der Ferne nicht replizieren kann.

ℹ️ Die in diesem Artikel bereitgestellten Informationen dienen ausschließlich bildenden und informativen Zwecken. Sie stellen keine Rechtsberatung sowie keine Handlungsempfehlung für den Einzelfall dar. Die Inhalte reflektieren den technischen und organisatorischen Kenntnisstand zum Zeitpunkt der Veröffentlichung und wurden nach bestem Wissen erstellt. IT-Sicherheit sowie Rechtsprechung unterliegen einem stetigen Wandel. Der Autor übernimmt keine Gewähr für die Aktualität sowie Richtigkeit und Vollständigkeit der bereitgestellten Informationen. Eine Haftung wird soweit gesetzlich zulässig ausgeschlossen. Die Umsetzung der beschriebenen Maßnahmen erfolgt eigenverantwortlich durch den Leser. Für eine verbindliche Bewertung juristischer Sachverhalte ist die Konsultation eines qualifizierten Rechtsanwalts oder Datenschutzbeauftragten unerlässlich.

Rechtlicher Rahmen: „Stand der Technik“ ist ein bewegliches Ziel

ℹ️ Die folgenden Ausführungen stellen eine technisch-organisatorische Einordnung juristischer Sachverhalte dar und ersetzen keine anwaltliche Beratung.

Die juristische Bewertung von IT-Sicherheitsvorfällen hat sich in den letzten Jahren drastisch verschärft. War es früher oft ausreichend eine Firewall und einen Virenscanner vorzuweisen, greifen heute strengere Maßstäbe. Geschäftsführer und IT-Verantwortliche müssen verstehen, dass Compliance kein statischer Zustand ist.

Art. 32 DSGVO (i. V. m. Erwägungsgrund 83):

Die Dynamik der Sorgfaltspflicht

Der Gesetzgeber fordert in Art. 32 DSGVO unter Berücksichtigung von Stand der Technik sowie Implementierungskosten und Risiko geeignete technische und organisatorische Maßnahmen. Erwägungsgrund 83 konkretisiert die risikobasierte Herangehensweise. Dieser Ansatz ist technologieneutral formuliert und verlangt eine stetige Anpassung an die Bedrohungslage.

Eine Sicherheitsarchitektur galt vor fünf Jahren vielleicht als angemessen und kann heute als unzureichend eingestuft werden. Wenn polymorphe Malware Standard-Virenscanner umgeht, kann ein reiner Signatur-Schutz je nach Schutzbedarf in der Regel nicht mehr als angemessene Maßnahme gelten. Aufsichtsbehörden und Gerichte prüfen im Schadensfall kritisch, ob die Schutzmaßnahmen an die realen Gefahren angepasst wurden.

Die Haftungsfalle: Organisationsverschulden

Im Falle eines Datenabflusses durch einen gezielten Angriff prüfen Behörden und Versicherungen die Kausalität. Es stellt sich die Frage, ob der Angriff lange unbemerkt bleiben konnte, weil geeignete Protokollierungsmechanismen fehlten. Fehlen essenzielle Sicherheitskomponenten oder eine funktionierende Log-Analyse, setzt sich das Unternehmen dem Risiko aus, dass dies als Organisationsverschulden oder sorgfaltswidriges Handeln gewertet wird.

Besondere Brisanz liegt im Versicherungsschutz. Versicherer prüfen im Schadensfall häufig, ob die im Antrag gemachten Angaben und die tatsächliche Sicherheitslage übereinstimmen. Abweichungen können je nach Konstellation vorvertragliche Rechtsfolgen nach §§ 19 ff. VVG und/oder Leistungskürzungen bei Obliegenheitsverletzungen nach § 28 VVG auslösen. Bei arglistigem Vorgehen bleibt zudem das Anfechtungsrecht nach § 22 VVG unberührt. Im Ergebnis kann der Versicherungsschutz erheblich eingeschränkt sein.

ℹ️ In meiner Funktion als Auditor für Zertifizierungsstellen ist es mir für einige Jahre untersagt, Unternehmen zu zertifizieren, die ich zuvor im Bereich Informationssicherheit beraten habe. Diese Regelung stellt die Unparteilichkeit und Integrität des Zertifizierungsverfahrens sicher.

Vertragliche Relevanz: Meldeketten und Geheimhaltung

Neben dem öffentlichen Recht spielen vertragliche Verpflichtungen eine zentrale Rolle. Mandatsverträge in Kanzleien oder Geheimhaltungsvereinbarungen in der Industrie enthalten oft Klauseln zur sofortigen Meldung von Sicherheitsvorfällen. Eine monatelange Verweildauer eines Angreifers im Netzwerk stellt hier ein massives Problem dar. Wenn ein Unternehmen technisch nicht in der Lage ist den Zeitpunkt des ersten Eindringens zu bestimmen oder den Abfluss von Daten sicher auszuschließen, muss es gegenüber Vertragspartnern oft vom schlimmsten Fall ausgehen. Dies kann Vertragsstrafen auslösen und das Vertrauensverhältnis nachhaltig zerstören. Die Investition in forensische Bereitschaft ist somit keine reine IT-Ausgabe und sie ist eine Maßnahme zur Risikominimierung im Vertragsmanagement.

ℹ️ Der VDA ISA (v6) fordert nicht ohne Grund in 1.6.2 und 7.1.1, dass die Unternehmen ihre gesetzlichen, regulatorischen und vertraglichen Pflichten identifiziert und entsprechend im ISMS (insbesondere im Incident Management) berücksichtigt haben.

Methodik der Bewertung: Vom passiven Scan zur aktiven Jagd

Die Beweisführung in einem Sicherheitsvorfall mit polymorpher Malware erfordert ein Umdenken. Wer nur auf die Alarmglocke seines Virenscanners wartet, hat den Kampf oft bereits verloren. Die moderne Bewertungsmethodik stützt sich nicht nur auf Signaturen, sie stützt sich auf Verhaltensdaten und Anomalien. Dies wird als „Threat Hunting“ bezeichnet. Microsoft bietet in seinen höheren Lizenzstufen (wie Business Premium oder E5) ein Arsenal an Werkzeugen. Diese bleiben jedoch in vielen Unternehmen unkonfiguriert.

Prävention: Die Angriffsfläche reduzieren

Der beste Indikator für einen Angriff ist der Angriff, der gar nicht erst stattfinden kann. Microsoft Defender for Endpoint bietet hierfür die „Attack Surface Reduction Rules“ (ASR).

Diese Regeln greifen tief in das Betriebssystem ein. Sie verbieten Verhaltensweisen, die für Malware typisch sind und im regulären Büroalltag selten vorkommen. Dazu gehört beispielsweise der Start von ausführbaren Dateien durch Office-Makros oder das Aufrufen von verschleierten Skripten. Ein Administrator kann konfigurieren, dass Adobe Reader keine Kind-Prozesse erstellen darf. Diese ASR-Regeln hätten die Ausführung vieler Dropper und Downloader im Keim erstickt bevor sie überhaupt Schadcode nachladen konnten.

Ein weiteres entscheidendes Feature ist der „Cloud-delivered Protection“ Modus mit der Funktion „Block at first sight“. Erkennt der lokale Defender eine Datei, die er noch nie gesehen hat, lädt er Metadaten oder die Datei selbst in Millisekunden in die Microsoft-Cloud. Dort wird sie durch Machine-Learning-Modelle analysiert. Wird sie als bösartig eingestuft, blockiert der Dienst die Ausführung weltweit auf allen verbundenen Geräten. Dies schließt das Zeitfenster zwischen dem ersten Auftreten einer neuen Malware-Variante und ihrer Erkennung drastisch.

Reaktion: Der Flugschreiber des Endgeräts

Wenn die Prävention versagt, schlägt die Stunde von EDR (Endpoint Detection and Response). Im Gegensatz zu einem klassischen Antivirus, der nur „Gut“ oder „Böse“ kennt, zeichnet ein EDR-System das gesamte Geschehen auf dem Endgerät auf.

Defender for Endpoint erstellt eine detaillierte Zeitleiste. Der Sicherheitsverantwortliche kann dort sehen, dass ein Benutzer um 14:02 Uhr eine Word-Datei öffnete. Er sieht, dass diese Datei um 14:03 Uhr eine Verbindung zu einer unbekannten IP-Adresse aufbaute und dass um 14:04 Uhr ein PowerShell-Skript ausgeführt wurde. Diese forensische Tiefe ist notwendig um den „Patient Zero“ zu identifizieren. Die Funktion „Automated Investigation and Remediation“ (AIR) geht noch einen Schritt weiter. Sie analysiert diese Alarme automatisch und prüft, ob ähnliche Muster auf anderen Geräten im Netzwerk existieren sowie isoliert betroffene Maschinen selbstständig.

Die Jagd mit KQL: Advanced Hunting

Für die tiefergehende Analyse bietet Microsoft das „Advanced Hunting“. Hierbei können Administratoren mit der Abfragesprache Kusto Query Language (KQL) die Rohdaten aller verbundenen Geräte durchsuchen.

Dies ist entscheidend bei der Suche nach IOCs (Indicators of Compromise). Wenn externe Quellen wie Hybrid-Analysis oder VirusTotal berichten, dass eine bestimmte Malware oft eine Datei namens update_fix.exe im Temp-Ordner ablegt oder eine spezifische Registry-Änderung vornimmt, kann der Administrator via KQL fragen: „Zeige mir alle Geräte, auf denen in den letzten 30 Tagen dieser Dateiname erstellt wurde“. Das Ergebnis liegt in Sekunden vor. Dies verwandelt die IT-Sicherheit von einer ratenden Instanz in eine wissende Instanz. Man sucht nicht mehr blind nach Viren und man sucht gezielt nach den Spuren des Einbruchs.

Identitätsschutz als letzte Bastion

Da moderne Angriffe oft auf den Diebstahl von Identitäten abzielen, muss die Analyse auch die Cloud-Logs umfassen. Entra ID (ehemals Azure AD) bietet mit „Identity Protection“ eine Risikoanalyse in Echtzeit.

Das System lernt das normale Verhalten eines Nutzers. Meldet sich Herr Müller jeden Tag aus München an und erfolgt plötzlich ein Login aus Lagos oder von einem anonymen Tor-Browser, schlägt das System Alarm. Über „Conditional Access“ Regelwerke kann festgelegt werden, dass bei einem solchen „Risky Sign-in“ der Zugriff blockiert wird oder der Benutzer zwingend sein Passwort ändern sowie eine MFA-Prüfung bestehen muss. Diese Verknüpfung von Endgeräte-Sicherheit und Identitäts-Schutz ist der effektivste Weg um die laterale Bewegung eines Angreifers im Netzwerk zu stoppen.

🥜 In A Nutshell: Von der Reaktion zur Resilienz

Der detaillierte Blick auf die Anatomie eines modernen Cyberangriffs führt zu einer unbequemen Erkenntnis. Die Strategie der absoluten Prävention ist gescheitert. Wer IT-Sicherheit heute noch als den Bau einer unüberwindbaren Mauer versteht, erhöht das Risiko massiv; im Schadensfall kann dies als unzureichendes Risikomanagement bewertet werden. Die Geschwindigkeit und die Adaptionsfähigkeit künstlicher Intelligenz auf Angreiferseite überholen statische Schutzmaßnahmen zwangsläufig.

Der Paradigmenwechsel: Assume Breach

Unternehmen müssen ihre Sicherheitsphilosophie vom Prinzip der Hoffnung auf das Prinzip der Realität umstellen. Dies wird in der Fachwelt als „Assume Breach“ bezeichnet. Man plant die Infrastruktur nicht unter der Annahme, dass der Angreifer draußen bleibt. Man baut Systeme unter der Prämisse, dass der Angreifer bereits im Netzwerk ist oder früher oder später hineingelangen wird.

Dieses Umdenken verändert die Investitionsstrategie grundlegend. Das Budget darf nicht mehr ausschließlich in präventive Schutzschilde fließen. Ein signifikanter Teil der Ressourcen muss in die Detektion und in die Reaktion investiert werden. Die entscheidende Kennzahl ist nicht mehr die Anzahl der blockierten Viren an der Firewall und sie ist die „Mean Time to Detect“. Dies beschreibt die Zeitspanne vom ersten Eindringen bis zur Entdeckung. In vielen Unternehmen liegt dieser Wert heute bei mehreren Monaten. Das Ziel muss sein diesen Wert auf Stunden oder Minuten zu drücken.

Sichtbarkeit als Überlebensfaktor

Die Analyse hat gezeigt, dass fehlende Sichtbarkeit das größte Risiko darstellt. Verschlüsselter Datenverkehr ohne Inspektion sowie unüberwachte Endgeräte und fehlende Protokolle machen das eigene Netzwerk zur Blackbox. Ein Angreifer kann sich in der Dunkelheit verstecken.

Die Antwort darauf ist radikale Transparenz. Jede Verbindung und jeder Prozessstart sowie jede Anmeldung muss protokolliert und automatisiert bewertet werden. Technologien wie EDR und SIEM (Security Information and Event Management) sind keine optionalen Werkzeuge für Großkonzerne mehr. Sie sind die Alarmanlagen des digitalen Mittelstands. Nur wer sieht was in seinem Netzwerk passiert, kann steuernd eingreifen.

Zero Trust als strategisches Ziel

Die technische Antwort auf den Identitätsdiebstahl und die laterale Bewegung im Netzwerk ist das Zero-Trust-Modell. Das alte Konzept des „vertrauenswürdigen internen Netzwerks“ ist tot. In einer Zero-Trust-Architektur wird keiner Entität vertraut. Weder dem Gerät noch dem Benutzer und auch nicht der Verbindung.

Jeder Zugriff auf Daten oder Dienste erfordert eine explizite Verifizierung. Ist der Benutzer wer er vorgibt zu sein? Ist das Gerät gesund und frei von Malware? Ist der Standort plausibel? Nur wenn alle Parameter grün sind, wird der Zugriff für diese eine Sitzung gewährt. Dies reduziert den Explosionsradius eines erfolgreichen Angriffs massiv. Selbst wenn ein Passwort gestohlen wird, bleibt der Zugriff auf kritische Ressourcen verwehrt, wenn der Kontext nicht stimmt.

Sicherheit ist kein Zustand, der durch den Kauf einer Software erreicht wird. Es ist ein fortlaufender Prozess der Härtung sowie der Überwachung und der Anpassung. Der vorliegende Fall ist ein Weckruf. Er zeigt, dass die Bedrohung real und fortgeschritten ist. Er zeigt aber auch, dass wir nicht wehrlos sind, wenn wir bereit sind alte Gewissheiten aufzugeben und Sicherheit neu zu denken.